Збір семантичного ядра: найповніший чек-лист 2026

Автор: Віталій Каспрук

керівник агентства семантики

Складено на наших помилках та досвіді.

З 2013 року агентство зібрало: 7200 семантичних ядер для seo-просування сайтів та контекстної реклами.

Розмір чек-листа: 12 етапів, 86 пунктів.

Хочете прокачати сайт? Знайти "легкі" ключі для SEO-просування? Дізнатися сильні та слабкі сторони конкурентів?

Довірте семантику нам! Ціна збору семантичного ядра

1. Узгодження завдання

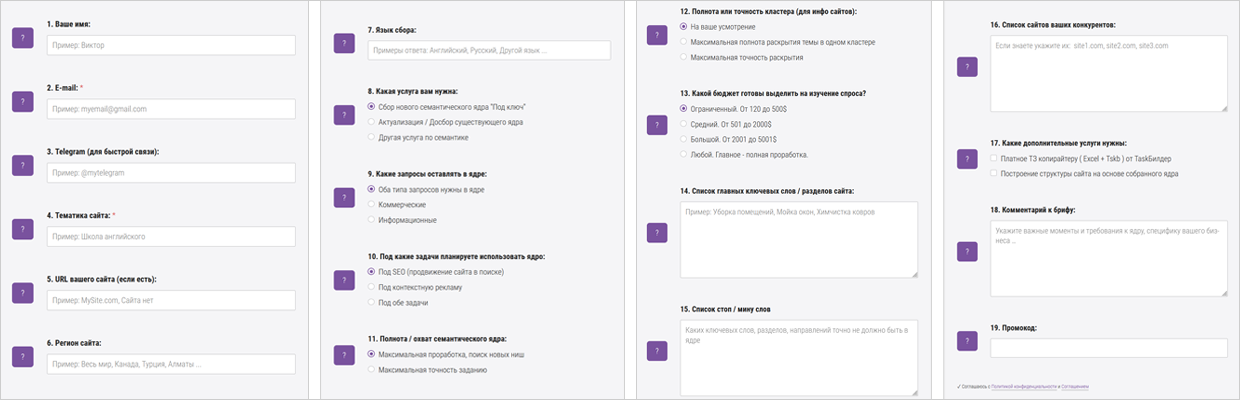

Проводимо збір даних. Вивчаємо завдання через розширений бриф (19 пунктів): перейти

◉ В середньому ми обговорюємо проект від 30 до 120 хвилин.

- Приклад 1. Занадто широке завдання: зібрати ядро на тему "шкіргалантерея". Ми зібрали 14000 ключів. При затвердженні пошукових запитів, завдання змінилося на "чоловічі шкіряні гаманці", а це лише 200 ключів.

- Приклад 2. Занадто вузьке завдання: зібрати всі послуги з "прибирання квартир".

В результаті втрачено низку послуг, по яким конкуренти отримують трафік та замовлення ("прибирання будинків і котеджів", "прибирання офісів", "прибирання дач", ...).

Приклад: неможливо зібрати за 10 днів і з бюджетом у 2000$ > ПОВНУ семантику для інтернет-магазину побутової техніки, якщо збирати всі бренди та номенклатуру побутової техніки.

Приклад: для вузької, але високомаржинальної тематики "елітна нерухомість" оптимальний поріг = 1, для широкої "продаж побутової техніки" від 2-5.

Якщо значно підняти поріг частотності запитів, видалиться великий % низькоконкурентних (низькочастотних) запитів у "нульовки" + можемо видалити нові запити, які тільки набирають популярність.

◉ Для сезонних тематик ключі краще збирати наприкінці сезону - це дасть змогу знайти до 99% поточного попиту.

Милиця: під час збирання не в сезон парсимо річну частотність і за нею чистимо «нульовки».

Приклад: «зимові шини» найкраще збирати наприкінці грудня - на початку січня.

Чітке розуміння, на кого розрахований наш блог, товар або послуга, дасть змогу підібрати найрелевантніші ключові слова.

Приклад: якщо компанія продає товари гуртом, тоді в ядрі ми орієнтуємося на b2b сегмент. Якщо в пошуковій видачі тільки роздрібні сайти, це не наше ключове слово.

2. Створення маркерів (базисів, масок) + Відбір конкурентів

Створюємо початковий список маркерів для парсингу + доповнюємо його на всіх етапах.

Аналізуємо прайс-лист, номенклатуру товарів, перелік послуг.

Маркер з великою базовою частотністю дасть багато низькочастотних запитів з "довгим хвостом".

Приклад маркерів для тематики клінінг: "чистка килимів", "прибирання квартир", "миття вікон".

По маркеру "прибирання" напарсимо багато сміття: "прибирання пшениці", "гра прибирання".

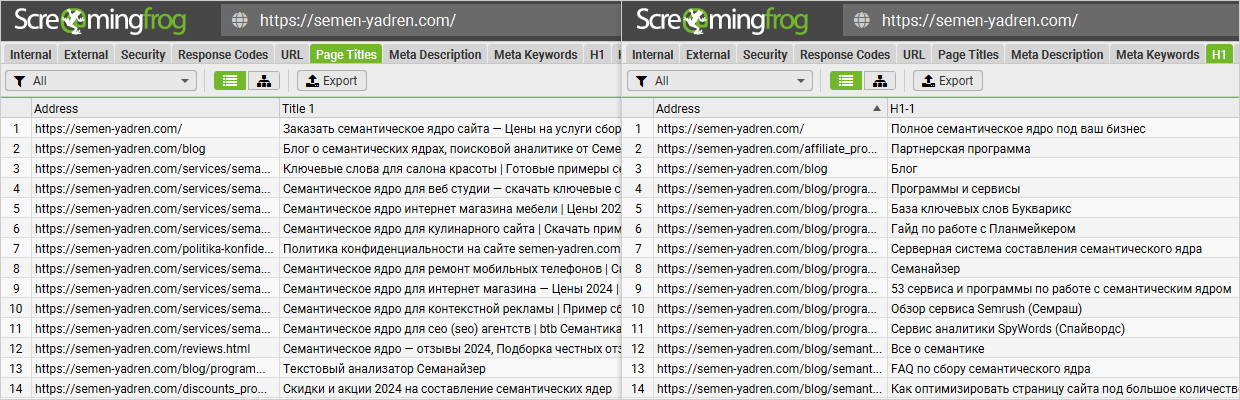

Аналізуємо сайт: категорії, розділи, меню, навігаційні ланцюжки, фільтри, теги, title, h1.

Використовуємо програми: "Screaming Frog SEO Spider", "Netpeak Spider", ...

◉ Ми використовуємо для аналізу Screaming Frog SEO Spider.

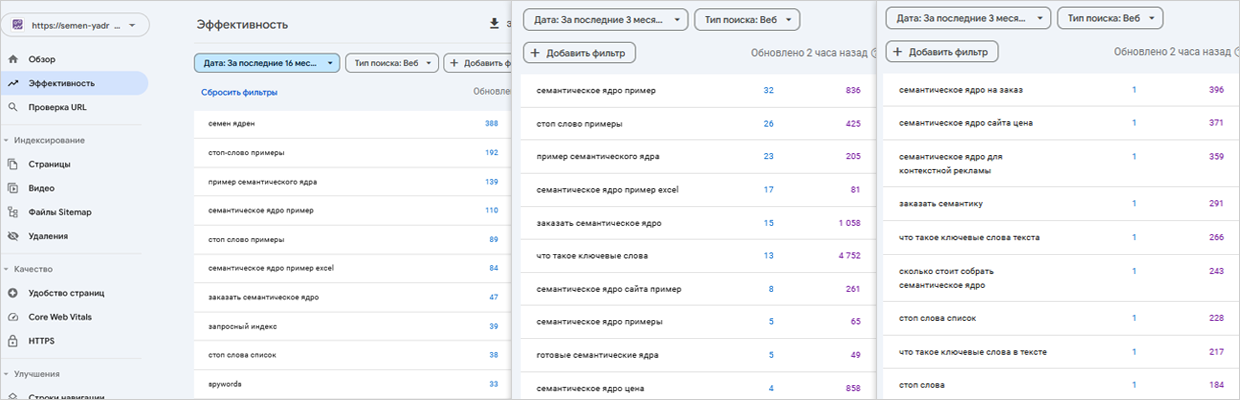

Актуально, якщо наш сайт існує певний час і на ньому є трафік. Приклад: "Google Search Console". Аналізуємо ВЧ (для вузьких тем: СЧ) запити.

◉ Ми використовуємо lookerstudio для експорту запитів за максимальний період.

- Приклад 1: послуга "підбір семантичного ядра" англійською для західних ринків буде: не "collection of semantic core", а "keyword research".

- Приклад 2: Користувачі часто вводять запити так, як чують: "кавомашина делонгі".

Формуємо список усіх брендів (виробників) і популярні варіанти їх написання.

Приклад: «Фольксваген», «Volkswagen», «Фольцваген», “Фольскваген”, «Вольксваген», ...

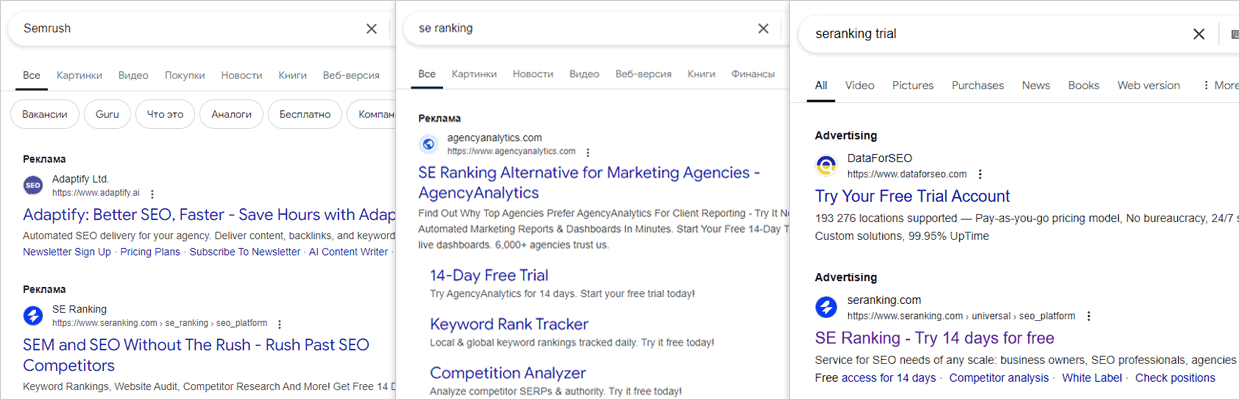

Часто надходить завдання зібрати семантику, наприклад, для сервісу "Se Ranking" + знайти брендові запити конкурентів ("Ahrefs", "Similarweb", ...) для показу контекстної реклами.

Тоді ми проводимо аналіз і включаємо в ядро ключі конкурентів.

Відсоток конверсій і продажів за такими фразами може суттєво відрізнятися в різних тематиках.

Розширюємо початкові маркери для парсингу. Пошук синонімів + урахування сленгу, професійної термінології, скорочень, абревіатур, різні варіанти написання або слова англійською.

- Приклад 1: "прибирання" = "клінінг".

- Приклад 2: "seo просування сайтів" = "розкрутка сайтів".

Перейти на: Вікіпедія | Словник синонімів

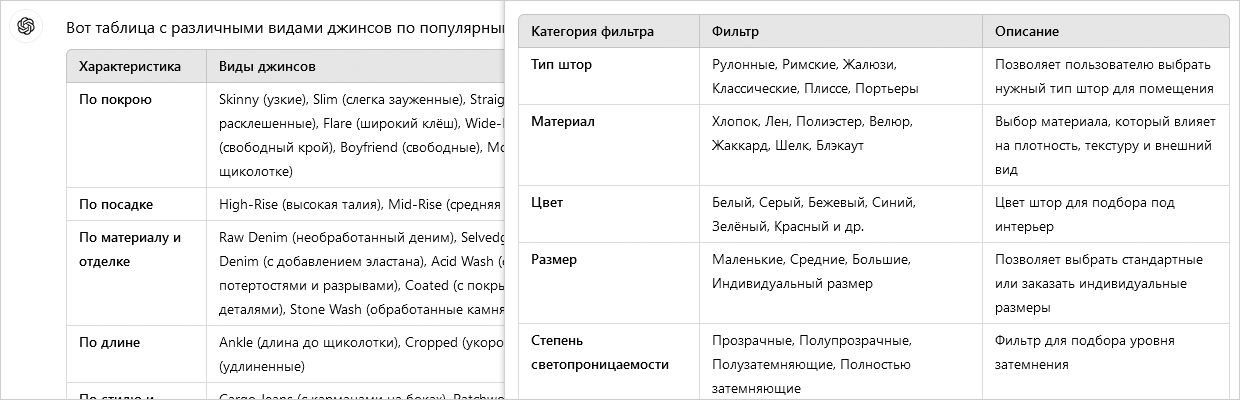

ChatGPT дозволяє швидко вивчити тематику сайту та терміни в ній.

- Приклад запиту 1: напиши всі види джинсів за різними популярними характеристиками.

- Приклад запиту 2: підбери ключові слова для seo під запит "семантичне ядро".

- Приклад запиту 3: створи оптимальний набір seo фільтрів для сайту з продажу штор.

Перейти на: ChatGPT | Gemini

◉ Наша актуальна добірка промптів по роботі з семантикою.

Проводимо пошук і аналіз сайтів конкурентів, максимально схожих на нас.

Не брати агрегатори та великі (старі) сайти з величезним трафіком.

Вони можуть додати до ядра мільйони "нецільових" запитів, і знадобляться дні (тижні) на чистку.

Перейти до звіту аналізу конкурентів: Serpstat, Semrush.

◉ Для проектів під Україну ми в агентстві використовуємо Serpstat, під "Бурж" - Semrush.

Для складних проектів формуємо початкову структуру в Xmind.

Початкова структура – це не фінальна структура нашого сайту, це "чернетка" поточної ситуації у конкурентів. Структура конкурентів може бути розроблена зовсім не на базі правильного семантичного ядра, не на основі поточного рівня попиту.

3. Підготовка до збору семантичного ядра

Оплачуємо ліцензію та абонплату, оновлюємо до останньої версії, налаштовуємо модулі розпізнавання. Перевіряємо коректність передачі та повернення розгаданої каптчі.

Використовуємо програми: "Xevil", "CapMonster", …

◉ З почату ми використовували CapMonster, але останні 4 роки перейшли повністю на Xevil (більше можливостей за меншу ціну).

Реєструємо акаунти в сервісах і поповнюємо баланс.

Перевіряємо коректність передачі та повернення розгаданої каптчі.

Використовуємо сервіси: "CapMonster cloud", "Anti-captcha.com", "Cap.Guru", "2Captcha", …

Реєструємо акаунти та поповнюємо баланс.

Перевіряємо роботу проксі-серверів для парсингу пошукових систем, сервісів і сайтів.

◉ Для розгадування reCAPTCHA ми використовуємо: Reproxy.network, для парсингу видачі добре показують себе проксі від A-Parser + власні серверні проксі.

Реєструємо акаунти та поповнюємо баланс.

Використовуємо SEO інструменти: "Serpstat", "SEMrush", "Ahrefs", "Similarweb", "Keys.so", …

Реєструємо акаунти + підтримуємо їх у робочому стані.

◉ Ми використовуємо сервіси: "Google Keyword Planner", "Google Search Console", "Wordstat", …

Від 50 - 80% під час збору семантики можуть займати артикули товарів.

Враховуємо це при погодженні завдання, парсингу та очищенні ключових слів.

Для інтернет-магазинів у семантиці буває більше кластерів під картки товару, ніж під категорії та розділи.

Приклад тематик: "автозапчастини", "побутова техніка", "серверне обладнання".

◉ Для побудови структури сайту, меню, хлібних крихт (навігаційних ланцюжків) такі запити не потрібні. А ось для налаштування контекстної реклами та ручної оптимізації сторінок під самі трафікові товарні запити навіть дуже потрібні.

Багато ключових слів не буває.

Встановлюємо максимально допустимий період для підбору семантики сайту.

Налаштовуємо потрібну мову для всіх сервісів і програм.

Для кожної мови збирається окреме семантичне ядро запитів.

Налаштовуємо потрібний регіон для всіх сервісів і програм.

Приклад: для інформаційних сайтів виставляємо - «Всі місцеположення / Без регіону».

◉ Виставляємо максимально широкий регіон, на скільки це дає змогу поставлене завдання.

Під час збору пошукової видачі правильно виставляємо параметр регіональності, щоб він формувався не на основі IP проксі-сервера, а на основі потрібного НАМ регіону.

Стаття: на MOZ, на Netpeak.

◉ Найкраще під Google використовувати параметр "&uule=".

Виставляємо ТОП 20 доменів для збору даних.

◉ У ТОП 10 не завжди вистачає "правильних" URL-адрес.

◉ У ТОП 10 часто знаходяться "великі, старі" сайти, на які не завжди варто орієнтуватися під час кластеризації ключових слів.

4. Збір (парсинг) ключових слів

◉ Збираємо ключові слова під пошукову оптимізацію сторінок і контекст за раніше складеними маркерами та відібраними доменами.

◉ Виставляємо максимальну глибину парсингу.

◉ Чим більше ключів зберемо на цьому етапі, тим більше цільових (релевантних) запитів залишиться після чистки.

Використовуємо: "Google Keyword Planner", "Trends.google.com", "Keywordtool.io", "Wordstat", …

Розпарсимо раніше підготовлені маркери.

Використовуємо: "Serpstat", "SEMrush", "Ahrefs", "Similarweb", "Keys.so", …

Парсимо за маркерами. Розмір бази: +7200 зібраних семантичних ядер, +22 000 000 ключів.

◉ Наша база поповнюється з 2013 року запитами після всіх етапів очищення від сміття.

Актуально, якщо наш сайт існує певний час і на ньому присутній трафік.

Використовуємо: "Google Search Console", "Webmaster.yandex.com".

* У пункті 2.3 чек-листа ми відбирали лише початкові маркери з високочастотних та середньочастотних запитів для парсингу "хвостів".

На даному етапі ми збираємо всю видимість нашого сайту в пошуку.

Для складання правильного та повного семантичного ядра обов'язково беремо запити конкурентів з безкоштовних, частково безкоштовних та платних сервісів.

Використовуємо: "Serpstat", "SEMrush", "Ahrefs", "Similarweb", "Keys.so", "Ads.google.com", …

Для парсингу пошукових підказок використовуємо SEO-інструменти: "A-parser.com", "Key-collector", власну серверну систему, ...

Для парсингу використовуємо: "A-parser.com", "Key-collector", власну серверну систему, …

При зборі семантики для локального бізнесу (локального SEO) опрацьовуємо фрази з топонімами (штат, район, місто, вулиця, метро).

Приклади тематик, де важливо опрацювати геолокації: "продаж нерухомості", "доставка їжі", "послуги з ремонту техніки", "медичні послуги", "послуги сантехніка", "послуги прибирання"...

Актуально для інформаційних сайтів або блогів.

Приклад: "Alsoasked.com", "Quora.com", …

5. Попередня чистка ключових слів від сміття, 1 етап

◉ Аналізуємо вміст ключових слів на наявність певних слів та "ознак".

◉ Для економії ресурсів очищення проводимо ПЕРЕД збором інформації з пошукової видачі, параметрів та сторінок конкурентів.

Використовуємо SEO-інструменти: "a-parser.com", "key-collector", власну серверну систему, ...

◉ На всіх етапах обов'язково візуально контролюємо, що видаляється у сміття.

Списки називаємо: "Сміття", "Інша причина видалення".

1. "Сміття" – 100% нецільові запити.

Приклад: В список переносимо ключі, що містять "безкоштовно" для комерційної тематики.

-

2. "Інша причина видалення" – запити збігаються з цільовими, але не підходять під бізнес.

Приклад: "прибирання квартир в Одесі" для клінінгової компанії з Києва.

Видаляємо нерелевантні групи ключових слів відносно нашої тематики чи бізнесу.

Приклад:

- Групи товарів (послуг) немає і не планується в нашому асортименті.

- Не наші бренди. В запиті згадуються агрегатори чи маркетплейси.

- "... безкоштовно" або " ... своїми руками" для комерційного проекту.

Відправляємо до списку: "Сміття".

За готовими списками топонімів видаляємо країни, регіони, міста, райони, вулиці та метро, в яких ми не працюємо.

◉ Контролюємо, щоб назва топоніма не збігалася точно чи частково з частиною запиту.

Приклад: Київ — для тематики з кулінарії (купити київський торт, київська котлета ціна).

Відправляємо до списку: "Інша причина видалення".

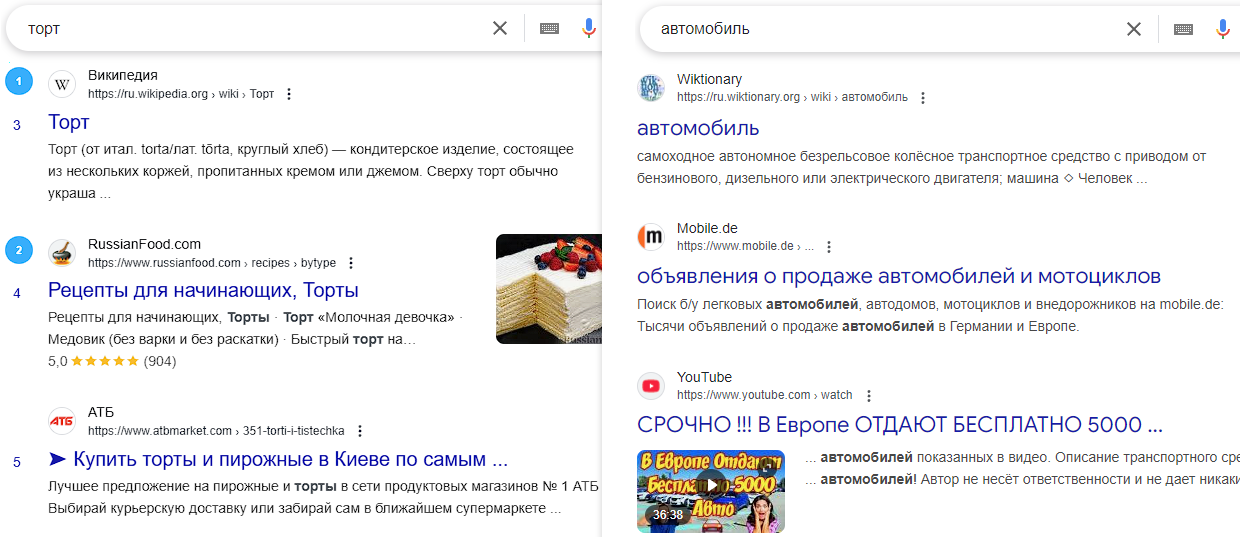

У 99% випадків у таких запитів незрозумілий інтент (намір) користувача, вони завжди мають кілька тлумачень. Якість трафіку та рівень конверсій (продажів) у однослівників - дуже низькі.

У таких ключів лише величезна конкуренція.

Приклад: "торт", "автомобіль", "семантика", "прибирання".

Відправляємо до списку: "Інша причина видалення".

При складанні семантичного ядра (СЯ) видаляємо дуже довгі пошукові запити, у яких більше 8, 9, 10 слів.

Приклад: "розділення повітря на компоненти в промисловості здійснюють методом дистиляції правда чи ні".

Відправляємо до списку: "Інша причина видалення".

Приклад: "1997 kawasaki gpz 1100 for sale", "toyokawa yuta".

Відправляємо до списку: "Інша причина видалення".

Приклад: "заміна масла маслом", "семантика що таке збір семантики".

Відправляємо до списку: "Інша причина видалення".

Актуально, якщо необхідно з семантики видалити товарний попит.

Приклад: "35257 майстер трактор з причепом 1", "kubota a155".

Відправляємо до списку: "Інша причина видалення".

Приклад: "заміна масла без", "в промисловості аміак отримують".

Відправляємо до списку: "Інша причина видалення".

Приклад: "як просунути сайт в ґуґлі 2015", "як замовити розкрутку сайта 2020".

Відправляємо до списку: "Інша причина видалення".

6. Збір параметрів і сторінок конкурентів

◉ Дані використовуємо для:

- Очищення від сміття.

- Автоматичної кластеризації запитів по ТОПам.

- Ручного доведення семантичного ядра до робочого стану.

- Формування різних звітів...

Один із головних етапів парсингу.

Контролюємо, щоб видача була зібрана для кожного пошукового запиту.

Зібрані дані використовуємо для:

- Пошуку кластерів для об'єднання за інтентами.

- Формування LSI-слів та фраз.

- Складання власних варіантів title та description, ...

Зібрані дані використовуємо для:

- Всіх цілей з попереднього пункту.

- Текстового аналізу та формування ТЗ для копірайтера.

Збираємо середню, точну, базову, річну частотність (за необхідності) у потрібному регіоні.

◉ В гуглі через Google Ads можна зібрати тільки середню. В Яндекс Вордстат можна зібрати точну з урахуванням порядку слів, точну, фразову та базову (в залежності від операторів).

Збираємо частотність запитів за 12/24 місяці для визначення сезонного попиту. Формуємо окремий звіт.

Для розрахунку використовуємо словники ознак:

- Інформаційний (як, яка, де, коли, wiki, info, article, …).

- Комерційний (купити, ціна, замовити, buy, …).

Аналізуємо ознаки в: "URL", "сніпетах", "мета тегах", "тексті сторінки", …

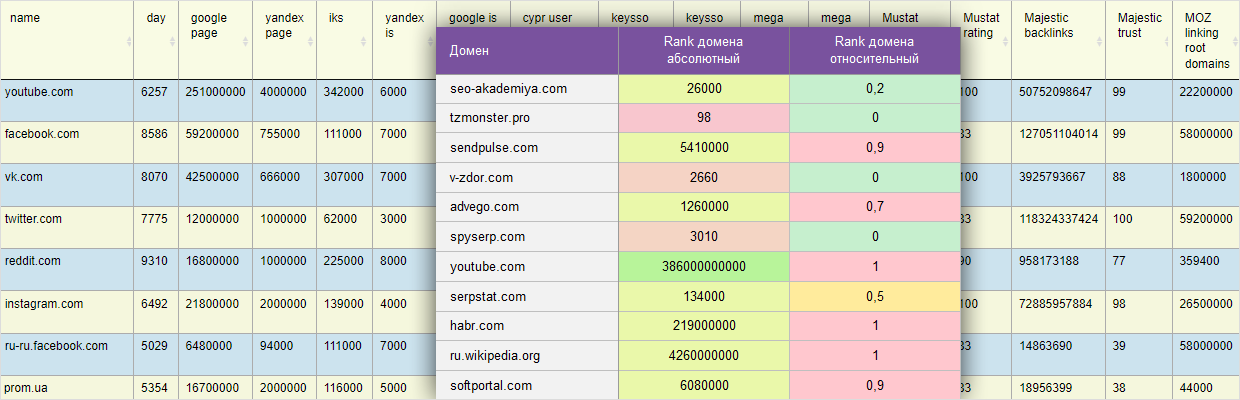

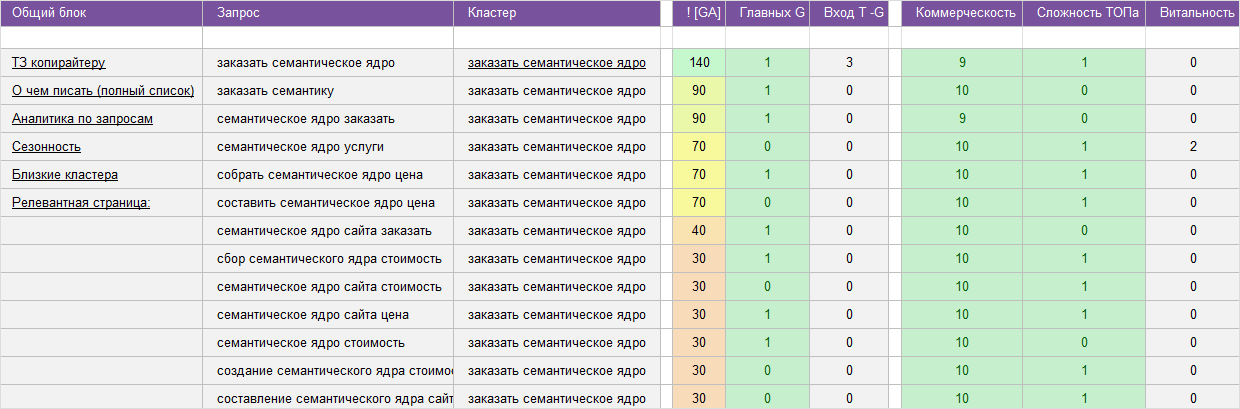

Назва параметра у звітах: "складність ТОПу", "Rank домену".

Чим більший коефіцієнт, тим складніше потрапити до ТОП 10 за запитом або тематикою в цілому.

Значення 0 - легко, 10 - дуже складно.

Rank розраховуємо за 22 параметрами з +10 сервісів: "вік домену", "трафік на домен", "кількість зворотних посилань та доменів", "кількість сторінок та згадок домену", …

◉ Не плутати з параметром Keyword Difficulty (KD) від Ahrefs, який розраховується виключно на зворотних лінках.

Аналізуємо тип сторінки: головна, внутрішня.

Приклад: якщо в ТОПі 9 головних сторінок, нам буде складно просунутися з внутрішньою сторінкою.

7. Підготовка до чистки ключових слів від сміття, етап 2

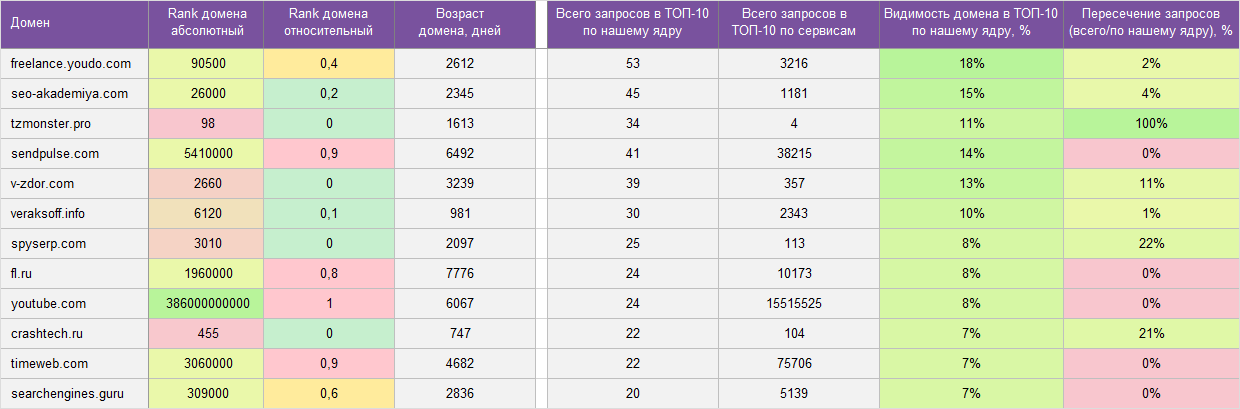

Аналізуємо ТОП 100 найбільш видимих доменів за ключами, які залишилися після 1 етапу.

До списку "мінус доменів" переносимо ті, які ТОЧНО нам не підходять.

Приклад: якщо у нас невеликий інтернет-магазин взуття, до мінус доменів потраплять агрегатори, маркетплейси, великі мультитоварні інтернет-магазини, вікіпедія, блоги, форуми,...

За аналогією з попереднім пунктом формуємо список "плюс доменів".

До списку додаємо лише дуже схожі за тематикою, номенклатурою чи послугами сайти.

Якщо у ТОПі пошукової видачі є певна кількість "плюс доменів", тоді з великою ймовірністю це наш товар чи послуга.

8. Чистка ключових слів від сміття, етап 2

◉ У всіх ключів, які потрапляють у мінус, вже зібрана пошукова видача та параметри - це нам знадобиться для подальшого очищення.

◉ На всіх етапах обов'язково візуально контролюємо ключові слова, які видаляються у сміття.

Підходи до вибору варіантів для видалення:

- Запити з нижчою складністю (Ahrefs KD).

- За конкуренцією або вартістю кліку (Google Ads).

- За найточнішою частотністю запиту (Wordstat ["!"]), яка враховує порядок слів.

- Випадковий вибір варіанту...

Приклад: "замовити прибирання квартири", "прибирання квартири замовити", "замовити прибирання у квартирі".

Відправляємо до списку: "Інша причина видалення".

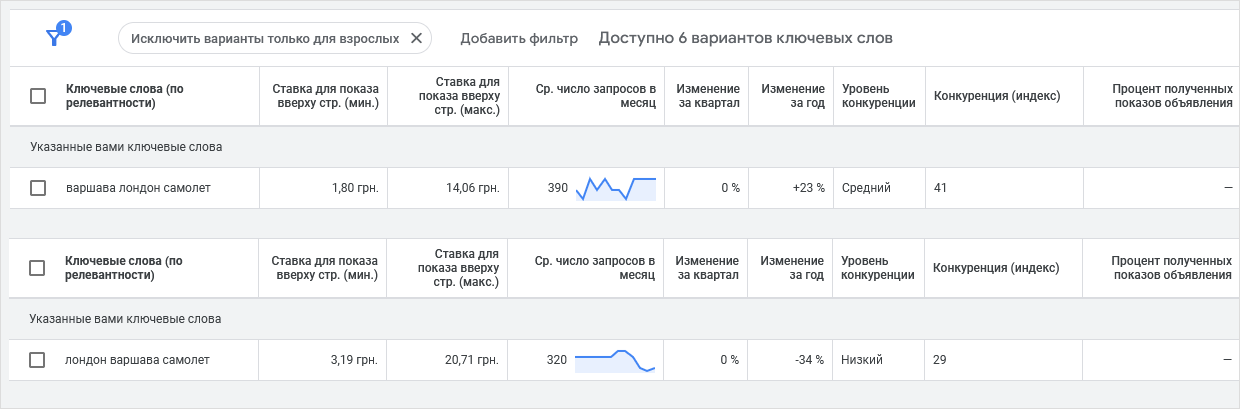

Для тематики сайтів: "тури", "авіаквитки", "перевезення", ... приділяємо максимальну увагу очищенню від неявних дублів, але не всі вони є неявними.

Приклад: "варшава лондон літак" та "лондон варшава літак" — це різні потреби користувачів, різні напрямки переїзду, різна частотність, вартість кліку та конкуренція.

Відправляємо до списку: "Інша причина видалення".

Приклад: ми збираємо всі комерційні ключі для приватної кондитерської, і є запит "торт наполеон" – у нього немає специфікатора, що визначає намір користувача.

Але в сніпетах і на сторінках конкурентів буде багато слів: рецепт, своїми руками, як...

Встановивши певний поріг частоти зустрічання стоп-слів, ми можемо видалити нецільові.

Відправляємо до списку: "Інша причина видалення".

Видаляємо всі запити, у яких частотність нижче встановленого порогу.

◉ Для вузьких, дорогих, промислових (b2b) тематик встановлюємо мінімальний поріг частотності = 1. Навіть один продаж на місяць дорогого продукту чи послуги може кілька разів покрити витрати на збір та впровадження семантики на сайт.

Низькочастотні ключі розширюють загальну видимість та запитний індекс сайту.

Відправляємо до списку: "Інша причина видалення".

Відбираємо запити, у яких у ТОП 10-20 багато URL-адрес зі списку "мінус доменів".

Наприклад: видаляємо запити, за якими у ТОПі відсутні домени близьких конкурентів, а присутні лише агрегатори, маркетплейси чи великі сайти з величезним трафіком.

Відправляємо до списку: "Інша причина видалення".

Якщо у семантичному ядрі не повинно бути ключів, по яким у ТОП 10 знаходиться одразу кілька URL-адрес одного домену. Найчастіше це брендові запити.

Приклад: "Nescafe", "Xiaomi", ...

Відправляємо до списку: "Інша причина видалення".

Увага! Є тематики, де потрібно додатково візуально перевіряти списки на видалення. Приклад: юридична та медична тематики, де по комерційним запитам знаходяться сторінки з дуже великими текстами і навіть є блок: "зміст".

◉ Для комерційного проекту залишаємо запити зі змішаною та комерційною видачею.

Відправляємо до списку: "Сміття" запити з коефіцієнтом комерційності від 0 до 3.

Формула розрахунку параметра: Повнота = (Точна / Базова частотність) * 100.

Запити з коефіцієнтом від 0 до 3 малоефективні.

Запити з низькою ефективністю/повнотою є занадто загальними або багатозначними, з малою часткою цільового трафіку.

Відправляємо до списку: "Інша причина видалення".

Видаляємо запити, у яких немає > 3 спільних URL-адрес у ТОП 10 з будь-яким іншим запитом зі списку.

Приклад: У нас після всіх попередніх етапів очищення залишилося 5000 ключів за тематикою "клінінг приміщень" і в цьому списку "затаїлися" 2 ключі "прибирання пшениці", "прибирання гра".

У цих 2 ключів правильний маркер "прибирання", але не буде спільних URL-адрес з іншими ключами + між ними теж не буде зв'язків. Це як окремі острови біля материка.

Відправляємо до списку: "Сміття".

Ключові слова, що залишилися, ми швидко кластеризуємо за Soft методом і візуально переглядаємо найбільші кластери (групи).

Відправляємо до списку: "Сміття".

Сортуємо ключові слова за параметрами: частотність, комерційність, алфавіт... і шукаємо сміття.

Якщо знаходимо, повторюємо попередні етапи очищення, які можуть усунути недоліки.

У результаті мають залишитися лише наші ключові слова.

Очищаємо ті запити, які мають сильні зв'язки (багато перетинів URL-адрес у ТОПі) із запитами, які ми видалили на попередніх етапах до списку "Сміття".

Приклад: ми раніше видалили запит "торт наполеон" для приватної кондитерської, і на даному етапі бачимо, що цей запит має 9 спільних URL-адрес із "торт наполеон швидко".

Отже, цей запит з 90% ймовірністю нам теж не підходить.

Знайдені ключові слова також відправляємо до списку: "Сміття".

Краще за власника ніхто не знає свій бізнес і які запити йому цікаві!

В особистому кабінеті користувача реалізовано затвердження груп ключових слів.

◉ Після перевірки власником бізнесу кількість сміттєвих запитів у фінальному списку (перед групуванням) близька до "0"!

Нецільові запити відправляємо до списку: "Сміття".

9. Авто кластеризація (групування) ключових слів по ТОПам

◉ Кластеризація по ТОПами не працює або працює дуже погано для нових, вузьких, низькоконкурентних тематик.

Для таких тематик дуже погано сформована видача, пошук підмішує різні типи сторінок.

Розподіл часу робіт на 9 та 10 етапі:

- 1 етап. Основне автоматичне групування по ТОПам (Hard, Soft, Middle) – лише 5% часу.

- 2 етап. Додаткове авто догрупування / дорозкидування по ТОПам – до 10% часу.

- 3 етап. Ручне доопрацювання результатів автомата семантистом – до 60% часу.

- 4 етап. Ручна перевірка результатів відділом якості - до 25% всього часу.

Кластеризація запитів проводиться у нашій серверній системі.

- Hard - для комерційних проектів.

- Soft - для інформаційних проектів.

Для кожного кластера формуємо ТОП 10 спільних релевантних URLів з урахуванням:

- Частотності запиту.

- Позиції URLів в ТОПі.

- Кількості запитів з кластера, за якими даний URL у ТОПі.

Для кластеризації використовуємо різні формули косинусної схожості (cosine similarity).

Аналізуємо набори популярних слів для кожного запиту, кластера.

◉ Список популярних слів формуємо з: слів запиту, сніпетів, текстів на сторінках конкурентів.

При формуванні списку кластерів на об'єднання аналізуємо загальні URLи у ТОПі тільки для головної (найчастотнішої) фрази в кластері.

10. Ручне доопрацювання і перевірка семантичного ядра

◉ Всі роботи проводимо в нашій серверній системі.

◉ Використовуємо різні спеціалізовані seo інструменти і модулі для прискорення ручної праці.

Пошукова видача не ідеальна. У тематиках, де вебмайстри ще не створили посадкові під всі інтенти користувачів, в один кластер можуть потрапити зовсім різні запити.

- Приклад 1: "мікропозики онлайн", "... без першого траншу", "... цілодобово", "... швидко".

- Приклад 2: "купити светр з оленями", "червоний светр з оленями", "синій светр з оленями".

- Приклад 3: "лего ніндзяго 11 сезон набори", "лего ніндзяго 9 сезон набори".

При автоматичній кластеризації все потрапило в один кластер, і ми вручну все розносимо.

У тематиках з великою конкуренцією, де вебмайстри орієнтуються виключно на видачу, а не на інтенти, можуть бути різні сторінки, що відповідають на одну потребу користувача.

Приклад: "купити взуття куома", "купити чоботи куома", "купити валянки куома".

Усі ці кластери можна об'єднати в одну групу.

У теорії це різні товари (чоботи, валянки), але фактично у цього бренду це один товар.

Усі ці товари у виробника зведені на 1 спільну сторінку, на 1 лістинг + візуально це той самий товар.

Для підвищення рентабельності написання статті допускається об'єднання кількох схожих НЧ (низькочастотних) підтем в одну велику ВЧ (СЧ) тему. Перед початком об'єднання обов'язково аналізуємо:

- Сумарну частотність таких кластерів.

- Чи створили конкуренти окремі сторінки по підтемах чи ні, скільки таких статей.

◉ Зручно аналізувати за наявністю головного ключа в назвах документів.

Приклад: "як вибрати котел" + "як вибрати газовий котел" + "як вибрати електрокотел" + "як вибрати твердопаливний котел".

У товарній семантиці користувачі дуже часто не дописують повну назву.

Приклад запитів для одного й того ж товару:

- "Aro team twinat duo" = "Aro team twinat duo 3 в 1".

- "Britax advansafix 3" = "Britax roemer advansafix iii sict".

Якщо розробка (формування) семантичного ядра сайту проводиться лише для жіночого одягу, тоді можна об'єднувати в один кластер:

- "Купити джинси" та "Купити джинси для жінок".

- "Купити куртку" та "Купити куртку для жінок".

◉ У загальних запитах нижча конверсія та продажі (входить попит на чоловічий та дитячий одяг) + складніше просунутися.

Актуально для інформаційних проектів. Наприклад, у ядрі є всього 3 кластери:

- Як почистити килим пароочисником.

- Як почистити м'які меблі пароочисником.

- Як почистити подушку пароочисником.

Зв'язків у ТОПі немає, але кластери невеликі і їх можна об'єднати спільною проблемою: "як почистити пароочисником".

Переносимо зі списку "Залишились не кластеризовані" запити в кластер з таким самим інтентом, але за якими ще немає зв'язків у ТОПі.

Причина: вебмайстри ще не встигли знайти нові запити та додати їх на сторінку (провести пошукову оптимізацію).

Ми знаходимо такі зв'язки за:

- Схожими наборами слів у сніпетах.

- Векторною схожістю в текстах...

Типи: головна, категорія (розділ, лістинг, тегова сторінка), картка товару, стаття, відгуки, калькулятор…

11. Вивантаження і формування всіх звітів семантичного ядра

Приклад:

- % Видимості релевантного URL конкурента за певним кластером у пошуку.

- Підбір та розрахунок рівня зв'язків схожих кластерів.

- Перетин запитів ядра конкурента з нашим...

Візуально перевіряємо список "Сміття" та видаляємо цільові маркери.

У ньому не повинно бути слів, які входять до фінального списку цільових (релевантних) запитів.

Список відмінно підходить для початкового налаштування контекстної реклами.

Приклад: для тематики "послуги клінінгової компанії" у списку НЕ повинно бути слів "прибирання", "клінінг", "ціна", "послуга", "замовити", "миття", "чистка", "клінінгова", ...

Наші звіти допоможуть вам ефективно провести пошукову оптимізацію сторінок вашого сайту, налаштувати контекстну рекламу, перевірити релевантність створеного контенту.

Приклад: "Основний звіт", "Сезонність", "Схожі кластери", "Структура", "ТОП доменів", "Найбільш видимі конкуренти кластера", "ТЗ для копірайтера", …

12. Здача семантичного ядра

Передача всіх звітів.

Zip архів доступний для завантаження в особистому кабінеті.

Висновки та рекомендації

| 1. | Використовуючи чек-лист для формування чіткого плану робіт зі збору семантичного ядра. Ви не пропустите жоден важливий етап. |

| 2. | Перед початком ви маєте чітко розуміти, що ви маєте отримати в результаті, що шукаємо, а що видаляємо. Використовуємо анкетування. |

| 3. | Формуємо список початкових маркерів (базисів, масок) для парсингу. |

| 4. | Підбираємо і детально вивчаємо близьких конкурентів. Головне: близьких! |

| 5. | Налаштовуємо всі інструменти. |

| 6. | Використовуємо платні та безкоштовні джерела ключових слів. |

| 7. | Збираємо, парсимо, збираємо, парсимо. |

| 8. | Чистимо, уважно чистимо, фільтруємо сміття. |

| 9. | Використовуємо автокластеризацію по ТОПам і допрацьовуємо вручну. Враховуємо інтент запиту і специфіку бізнесу. |

| 10. | Формуємо зручний і візуально зрозумілий формат звітів. |

| 11. | Актуалізація. Дослідження ключових слів має бути безперервним процесом. Потреби користувачів постійно змінюються. |