Сбор семантического ядра: самый полный чек-лист 2025

Автор: Виталий Каспрук

руководитель агентства семантики

Составлено на наших ошибках и опыте.

С 2013 года агентство собрало: 7200 семантических ядер под seo продвижение сайтов и контекстную рекламу.

Размер чек-листа: 12 этапов, 86 пунктов.

Хотите прокачать сайт? Найти "легкие" ключи для seo продвижения? Узнать сильные и слабые места конкурентов?

Делегируйте семантику нам! Цены на сбор семантического ядра

1. Согласование задания

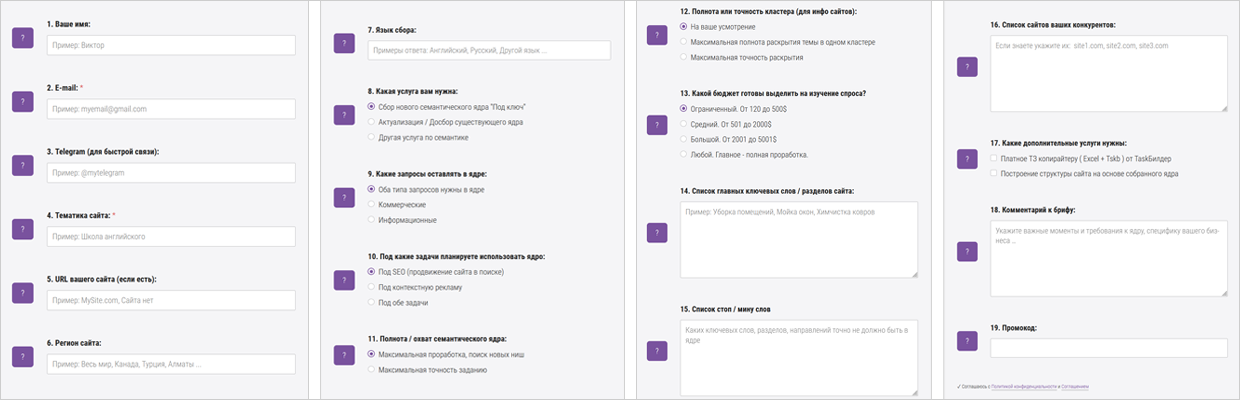

Проводим сбор данных. Изучаем задачу через расширенный бриф (19 пунктов): перейти

◉ В среднем мы обсуждаем проект от 30 до 120 минут.

- Пример 1. Слишком широкое задание: собрать ядро на тему "кожгалантерея". Мы собрали 14000 ключей. На утверждении ключей, задача поменялась на "мужские кожаные кошельки", а это 200 ключей.

- Пример 2. Слишком узкое задание: собрать все услуги по "уборке квартир".

В результате потерян ряд услуг, по которым конкуренты получают трафик и заказы (“уборка домов и коттеджей”, “уборка офисов”, “уборка дачи”, ...).

Пример: невозможно собрать за 10 дней и с бюджетом в 2000$ > ПОЛНУЮ семантику для интернет-магазина бытовой техники, если собирать все бренды и номенклатуру бытовой техники.

Пример: для узкой, но высокомаржинальной тематики "элитная недвижимость" оптимальный порог = 1, для широкой "продажа бытовой техники" от 2-5.

Если сильно поднять порог частотности запросов, удалиться большой % низкоконкурентных (низкочастотных) запросов в "нулевки" + можем удалить новые запросы, которые только набирают популярность.

◉ Для сезонных тематик ключи лучше собирать в конце сезона — это позволит найти до 99% текущего спроса.

Костыль: при сборе не в сезон, парсим годовую частотность и по ней чистим "нулевки".

Пример: "зимние шины" лучше всего собирать в конце декабря - начале января.

Четкое понимание, на кого рассчитан наш блог, товар или услуга, позволит подобрать наиболее релевантные ключевые слова.

Пример: если компания продает товары оптом, тогда в ядре мы ориентируемся на b2b сегмент. Если в поисковой выдаче только розничные сайты, это не наше ключевое слово.

2. Создание начальных маркеров (базисов, масок) + Отбор конкурентов

Создаем начальный список маркеров для парсинга + дополняем его на всех этапах.

Анализируем прайс-лист, номенклатуру товаров, список услуг.

Маркер с большой базовой частотностью даст много низкочастотных запросов с "длинным хвостом".

Пример маркеров для тематики клининг: "чистка ковров", "уборка квартир", "мойка окон", ...

По маркеру "уборка" напарсим много мусора: "уборка пшеницы", "уборка игра", …

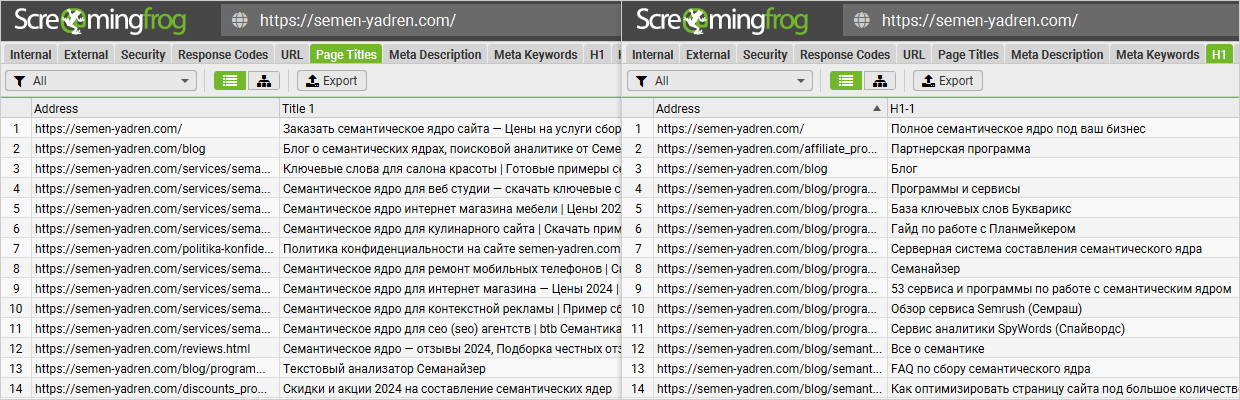

Анализируем сайт: категории, разделы, меню, хлебные крошки, фильтры, теги, title, h1.

Используем программы: "Screaming Frog SEO Spider", "Netpeak Spider", …

◉ Мы используем для анализа Screaming Frog SEO Spider.

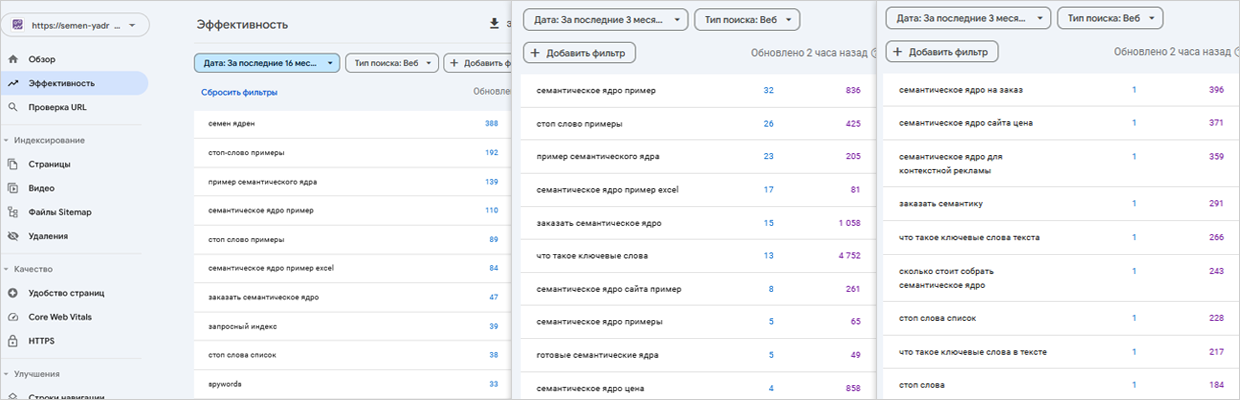

Актуально, если наш сайт существует определенное время и на нем присутствует трафик. Пример: "Google search console". Анализируем ВЧ (для узких тем: СЧ) запросы.

◉ Мы используем lookerstudio для экспорта запросов за максимальный период.

- Пример 1: услуга "подбор семантического ядра" на английском под западные рынки будет: не "collection of semantic core", а "keyword research".

- Пример 2: Пользователи часто вводят запросы так, как слышат: "кофемашина делонги".

Формируем список всех брендов (производителей) и популярные варианты их написания.

Пример: "Фольксваген", "Volkswagen", "Фольцваген", "Фольскваген", "Вольксваген", …

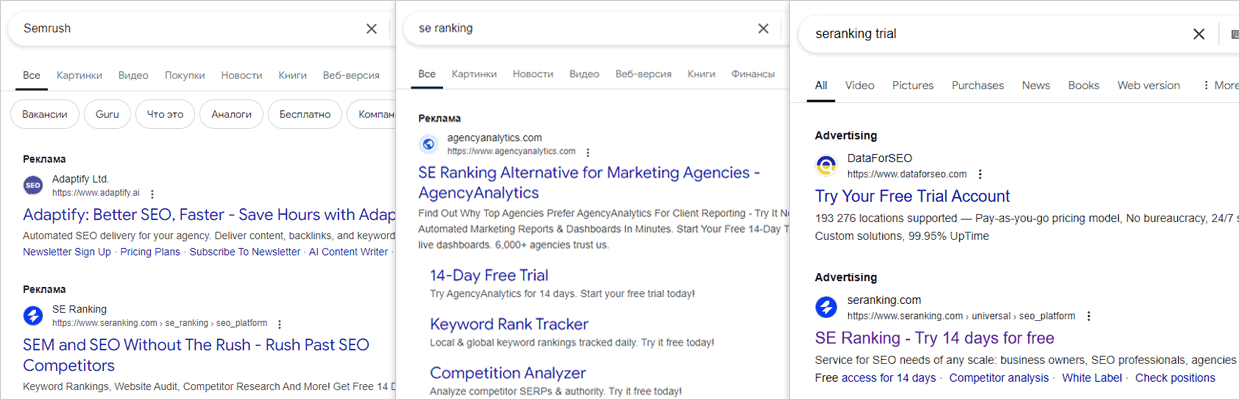

Часто приходит задача собрать семантику, например, для сервиса "Se Ranking" + найти брендовые запросы конкурентов ( "Ahrefs", "Similarweb", ...) для показа контекстной рекламы.

Тогда мы проводим анализ и включаем в ядро ключи конкурентов.

Процент конверсий и продаж по таким фразам может сильно меняться в разных тематиках.

Расширяем начальные маркеры для парсинга. Поиск синонимов + учет сленга, профессиональной терминологии, сокращений, аббревиатур, разные варианты написания или слова на английском.

- Пример 1: "уборка" = "клининг".

- Пример 2: "seo продвижение сайтов" = "раскрутка сайтов".

Перейти на: Википедия | Словарь синонимов

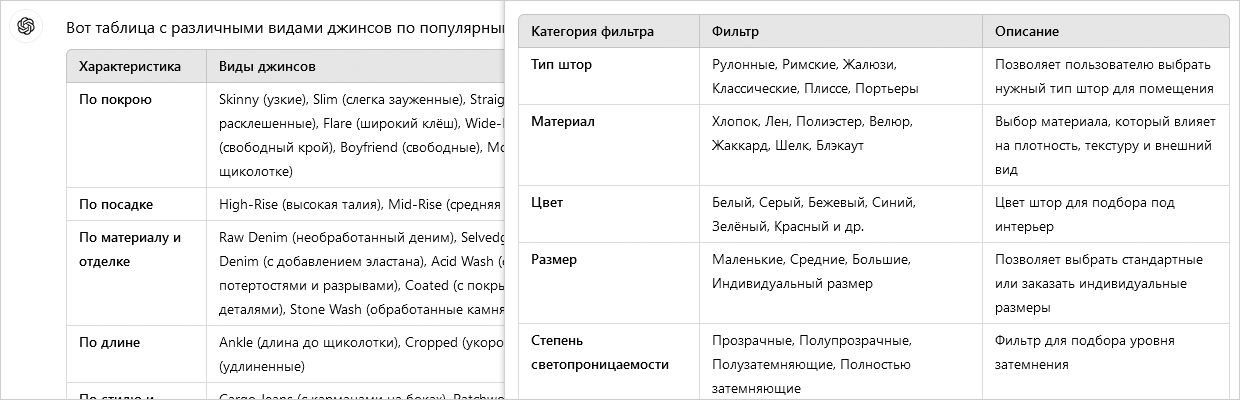

ChatGPT позволяет быстро изучить тематику сайта и термины в ней.

- Пример запроса 1: напиши все виды джинсов по разным популярным характеристикам.

- Пример запроса 2: подбери ключевые слова для seo под запрос "семантическое ядро".

- Пример запроса 3: создай оптимальный набор seo фильтров для сайта по продаже штор.

Перейти на: ChatGPT | Gemini |

◉ Наша актуальная подборка промптов для работы с семантикой.

Проводим поиск и анализ сайтов конкурентов максимально похожих на нас.

Не брать агрегаторы и большие (старые) сайты с огромным трафиком.

Они могут добавить в ядро миллионы "нецелевых" запросов и надо дни (недели) на чистку.

Перейти в отчет анализа конкурентов: Serpstat, Semrush, Keys.so.

◉ Для русскоязычных проектов мы в агентстве используем сервисы Serpstat или Keys.so, под "Бурж" - Semrush.

Для сложных проектов формируем начальную структуру в Xmind.

Начальная структура – это не финальная структура нашего сайта, это "набросок" текущей ситуации у конкурентов. Структура конкурентов может быть разработана совсем не на базе правильного семантического ядра, не на основе текущего уровня спроса.

3. Подготовка к сбору семантического ядра

Оплачиваем лицензию и абонплату, обновляем до последней версии, настраиваем модули распознавания. Проверяем корректность передачи и возврата разгаданной капчи.

Используем программы: "Xevil", "CapMonster", …

◉ Мы использовали Capmonster, но последние 4 года полностью переключились на Xevil (больше возможностей по меньшей цене)..

Регистрируем аккаунты в сервисах и пополняем баланс.

Проверяем корректность передачи и возврата разгаданной капчи.

Используем сервисы: "CapMonster cloud", "Anti-captcha.com", "Cap.Guru", "2Captcha", …

Регистрируем аккаунты и пополняем баланс.

Проверяем работу прокси серверов для парсинга поисковых систем, сервисов и сайтов.

◉ Для разгадывания reCAPTCHA мы используем: Reproxy.network, для парсинга выдачи хорошо показывают себя прокси от A-Parser + свои серверные прокси.

Регистрируем аккаунты и пополняем баланс.

Используем seo инструменты: "Serpstat", "SEMrush", "Ahrefs", "Similarweb", "Keys.so", …

Регистрируем аккаунты + поддерживаем их в рабочем состоянии.

◉ Мы используем сервисы: "Google Keyword Planner", "Google Search Console", "Wordstat", …

От 50 - 80% при сборе семантики могут занимать артикулы товаров.

Учитываем это при согласовании задачи, парсинге и чистке ключевых слов.

Для интернет-магазинов в семантике бывает больше кластеров под карточки товара, чем под категории и разделы.

Пример тематик: "автозапчасти", "бытовая техника", "серверное оборудование".

◉ Такие запросы не требуются для создания структуры сайта, меню, хлебных крошек (навигационных цепочек). Но для настройки контекстной рекламы и ручной оптимизации страниц под самые трафиковые запросы даже очень необходимы.

Много ключевых слов не бывает.

Выставляем максимально допустимый период для подбора семантики сайта.

Настраиваем нужный язык для всех сервисов и программ.

Для каждого языка собирается отдельное семантическое ядро запросов.

Настраиваем нужный регион для всех сервисов и программ.

Пример: для информационных сайтов выставляем - "Все местоположения / Без региона".

◉ Выставляем максимально широкий регион, на сколько это позволяет поставленная задача.

При сборе поисковой выдачи правильно выставляем параметр региональности, чтобы он формировался не на основе IP прокси сервера, а на основе нужного НАМ региона.

Статья: на MOZ , на Netpeak.

Под Google лучше всего использовать параметр "&uule=".

4. Сбор (парсинг) ключевых слов

◉ Собираем ключевые слова под поисковую оптимизацию страниц и контекст по ранее составленным маркерам и отобранным доменам.

◉ Выставляем максимальную глубину парсинга.

◉ Чем больше ключей соберем на данном этапе, тем больше целевых (релевантных) запросов останется после чистки.

Используем: "Google Keyword Planner", "Trends.google.com", "Keywordtool.io", "Wordstat", …

Распарсим ранее подготовленные маркеры.

Используем: "Serpstat", "SEMrush", "Ahrefs", "Similarweb", "Keys.so", …

Парсим по маркерам. Размер базы: +7200 собранных семантических ядер, +22 000 000 ключевых слов.

◉ Наша база пополняется с 2013 года запросами после всех этапов чистки от мусора.

Актуально, если наш сайт существует определенное время и на нем присутствует трафик.

Используем: "Google Search Console", "Webmaster.yandex.com".

* В пункте 2.3 чек-листа мы отбирали только начальные маркеры из высокочастотных и среднечастотных запросов для парсинга "хвостов".

А на данном этапе мы собираем всю видимость нашего сайта в поиске.

Для составления правильного и полного семантического ядра обязательно берем запросы конкурентов из бесплатных, частично бесплатных и платных сервисов.

Используем: "Serpstat", "SEMrush", "Ahrefs", "Similarweb", "Keys.so", "Ads.google.com", …

Для парсинга поисковых подсказок используем seo инструменты: "A-parser.com", "Key-collector", собственную серверную систему, …

Для парсинга используем: "A-parser.com", "Key-collector", собственную серверную систему, …

При сборе семантики для локального бизнеса (локального seo) прорабатываем фразы с топонимами (штат, район, город, улица, метро).

Пример тематик, где важно проработать геолокации: "продажа недвижимости", "доставка еды", "услуги по ремонту техники", "медицинские услуги", "услуги сантехника", "услуги уборки"…

Актуально для информационных сайтов или блогов.

Пример: "Alsoasked.com", "Quora.com", …

5. Предварительная чистка ключевых слов от мусора, 1 этап

◉ Анализируем содержимое ключей на наличие определенных слов и "признаков".

◉ Для экономии ресурсов чистку проводим ДО сбора информации из поисковой выдачи, параметров и страниц конкурентов.

Используем seo инструменты: "a-parser.com", "key-collector", собственную серверную систему, …

◉ На всех этапах обязательно визуально контролируем, что удаляется в мусор.

Списки называем: "Мусор", "Другая причина удаления".

1. "Мусор" – 100% нецелевые запросы.

Пример: В список переносим ключи, содержащие "бесплатно" для коммерческой тематики.

-

2. "Другая причина удаления" – запросы совпадают с целевыми, но не подходят под бизнес.

Пример: "уборка квартир в Алматы" для клининговой компании из Вильнюса.

Удаляем нерелевантные группы ключевых слов относительно нашей тематики или бизнеса.

Пример:

- Группы товаров (услуг) нет и не планируется в нашем ассортименте.

- Не наши бренды. В запросе упоминаются агрегаторы или маркетплейсы.

- "... бесплатно" или " ... своими руками" для коммерческого проекта.

Отправляем в список: "Мусор".

По готовым спискам топонимов удаляем страны, регионы, города, районы, улицы и метро, в которых мы не работаем.

◉ Контролируем, чтобы название топонима не совпало точно или частично с частью запроса.

Пример: Киев — для тематики по кулинарии (купить киевский торт, киевская котлета цена).

Отправляем в список: "Другая причина удаления".

В 99% случаев у таких запросов не понятен интент (намерение) пользователя, у них всегда несколько толкований. Качество трафика и уровень конверсий (продаж) у однословника - очень низкое.

У таких ключей только конкуренция огромная.

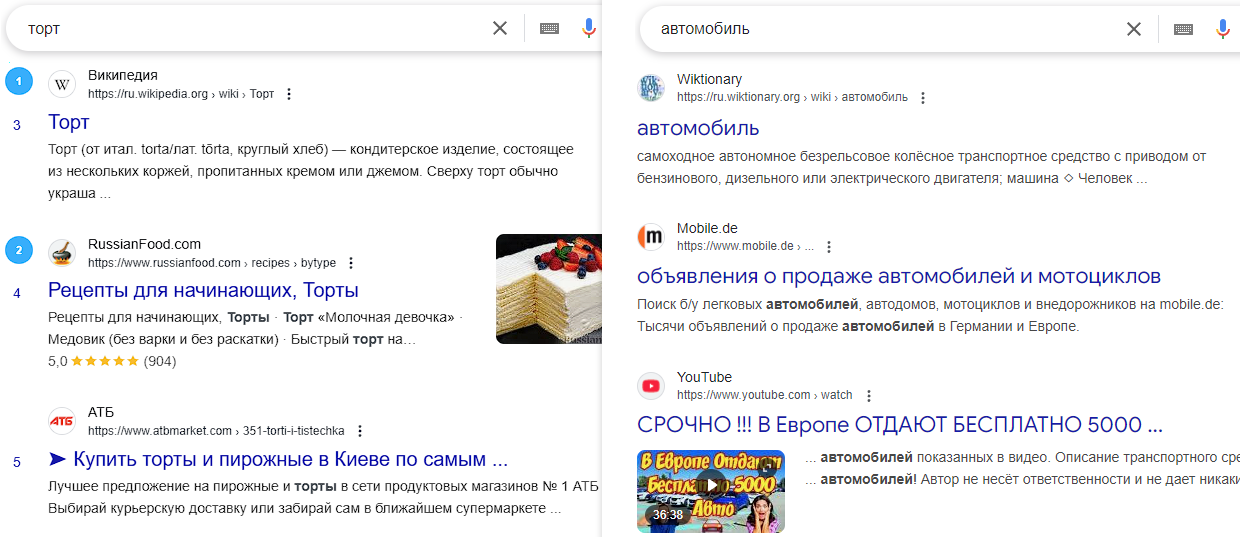

Пример: "торт", "автомобиль", "семантика", "уборка".

Отправляем в список: "Другая причина удаления".

При составлении семантического ядра (СЯ) удаляем очень длинные поисковые запросы, у которых больше 8, 9, 10 слов.

Пример: "разделение воздуха на компоненты в промышленности осуществляют методом дистилляции правда или нет".

Отправляем в список: "Другая причина удаления".

Пример: "1997 kawasaki gpz 1100 for sale", "toyokawa yuta".

Отправляем в список: "Другая причина удаления ".

Пример: "замена масла маслом", "семантика что такое сбор семантики".

Отправляем в список: "Другая причина удаления".

Актуально, если необходимо из семантики удалить товарный спрос.

Пример: "35257 мастер трактор с прицепом 1", "kubota a155".

Отправляем в список: "Другая причина удаления".

Пример: "замена масла без", "в промышленности аммиак получают".

Отправляем в список: "Другая причина удаления".

Пример: "как продвинуть сайт в гуле 2015", "как заказать раскрутку сайта 2020".

Отправляем в список: "Другая причина удаления".

6. Сбор параметров и страниц конкурентов

◉ Данные используем для:

- Чистки от мусора.

- Автоматической кластеризации запросов по ТОПам.

- Ручной доработки семантического ядра до рабочего состояния.

- Формирования различных отчетов…

Один из главных этапов парсинга.

Контролируем, чтобы выдача была собрана для каждого поискового запроса.

Собранные данные используем для:

- Поиска кластеров для объединения по интентам.

- Формирования LSI слов и фраз.

- Составления своих вариантов title и description, …

Собранные данные используем для:

- Всех целей из предыдущего пункта.

- Текстового анализа и формирования ТЗ для копирайтера.

Собираем среднюю, точную, базовую, годовую частотность (при необходимости) в нужном регионе.

◉ В гугле через Google Ads можно собрать только среднюю. В Яндекс Вордстат можно собрать точную с учетом порядка слов, точную, фразовую и базовую (в зависимости от операторов).

Собираем частотность запросов за 12/24 месяца для определения сезонного спроса. Формируем отдельный отчет.

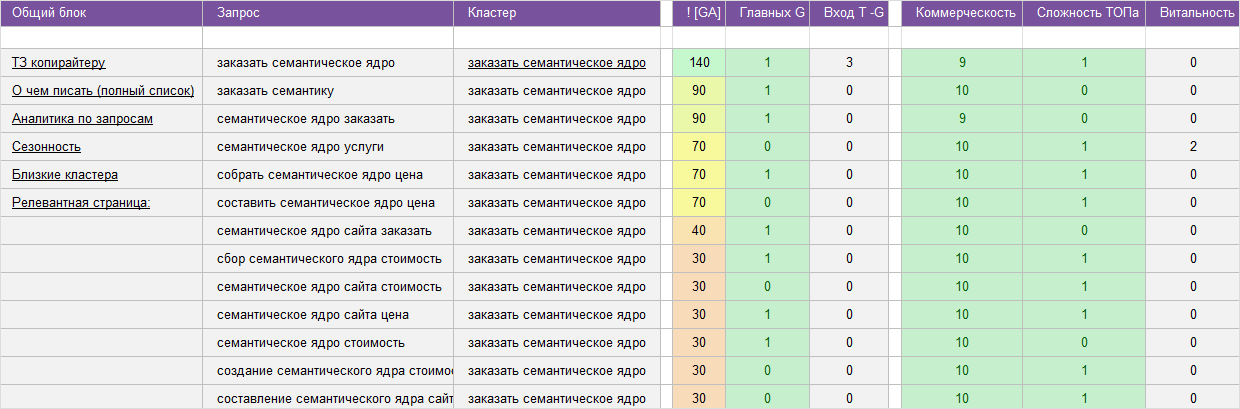

Для расчета используем словари признаков:

- Информационный (как, какая, где, когда, wiki, info, article, …).

- Коммерческий (купить, цена, заказать, buy, …).

Анализируем признаки в: "URL", "сниппетах", "мета тегах", "содержимое страницы", …

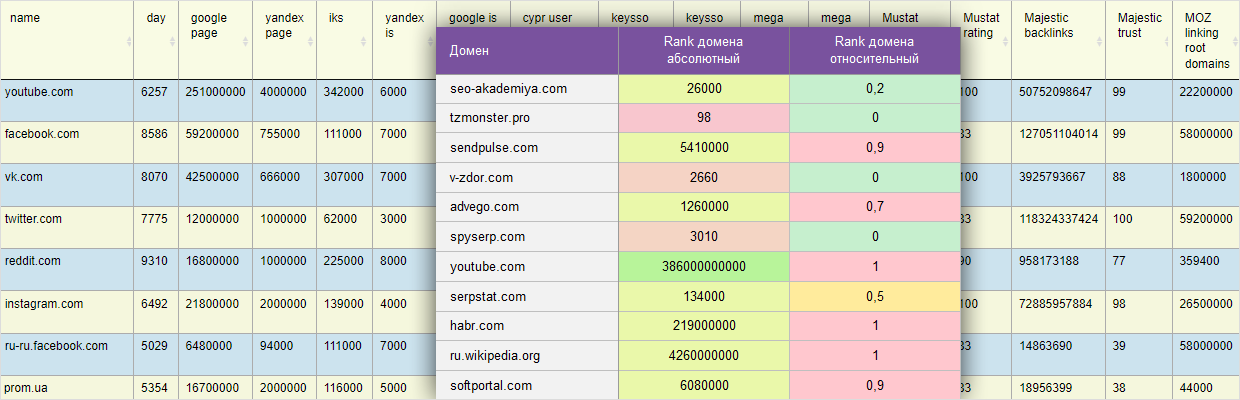

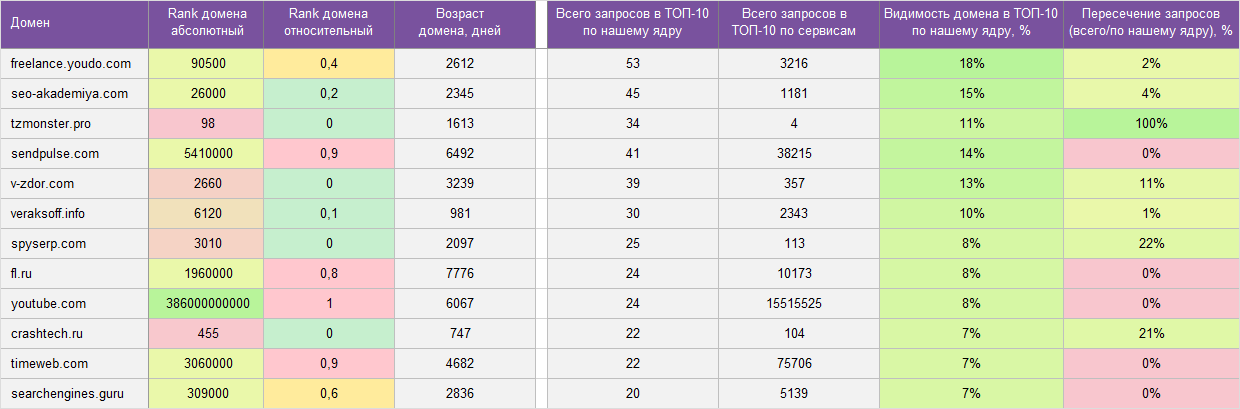

Название параметра в отчетах: "сложность ТОПа", "Rank домена".

Чем больше коэффициент, тем сложнее попасть в ТОП 10 по запросу или тематику в целом.

Значение 0 - просто, 10 - очень сложно.

Rank рассчитываем по 22 параметрам из +10 сервисов: "возраст домена", "трафик на домен", "кол. обратных ссылок и доменов", "количество страниц и упоминаний домена", …

◉ Не путать с параметром Keyword Difficulty (KD) от Ahrefs, который рассчитывается исключительно на обратных ссылках.

Анализируем тип страницы: главная, внутренняя.

Пример: если в ТОПе 9 главных страниц, нам будет сложно продвинуться с внутренней страницей.

7. Подготовка к чистке ключевых слов от мусора, этап 2

Анализируем ТОП 100 самых видимых доменов по ключам, которые остались после 1 этапа.

В список "минус доменов" переносим те, которые ТОЧНО нам не подходят.

Пример: если у нас небольшой интернет-магазин обуви в минус домены попадут агрегаторы, маркетплейсы, большие мультитоварные интернет-магазины, википедия, блоги, форумы, …

По аналогии с предыдущим пунктом формируем список "плюс доменов".

В список добавляем только очень похожие для нас по теме, номенклатуре или услугам сайты.

Если в ТОПе поисковой выдачи присутствует определенное количество "плюс доменов", тогда с большой долей вероятности это наш товар или услуга.

8. Чистка ключевых слов от мусора, этап 2

◉ У всех ключей, которые попадают в минус уже собрана поисковая выдача и параметры, это нам пригодится для дальнейшей чистки.

◉ На всех этапах обязательно визуально контролируем ключевые слова, которые удаляются в мусор.

Подходы к выбору вариантов на удаление:

- Запросы с более низкой сложностью (Ahrefs KD).

- По конкуренцией или стоимости клика (Google Ads).

- По самой точной частотности запроса (Wordstat ["!"] ), которая учитывает порядок слов.

- Случайный выбор варианта...

Пример: "заказать уборку квартиры", "уборку квартиры заказать", "заказать уборку в квартире".

Отправляем в список: "Другая причина удаления".

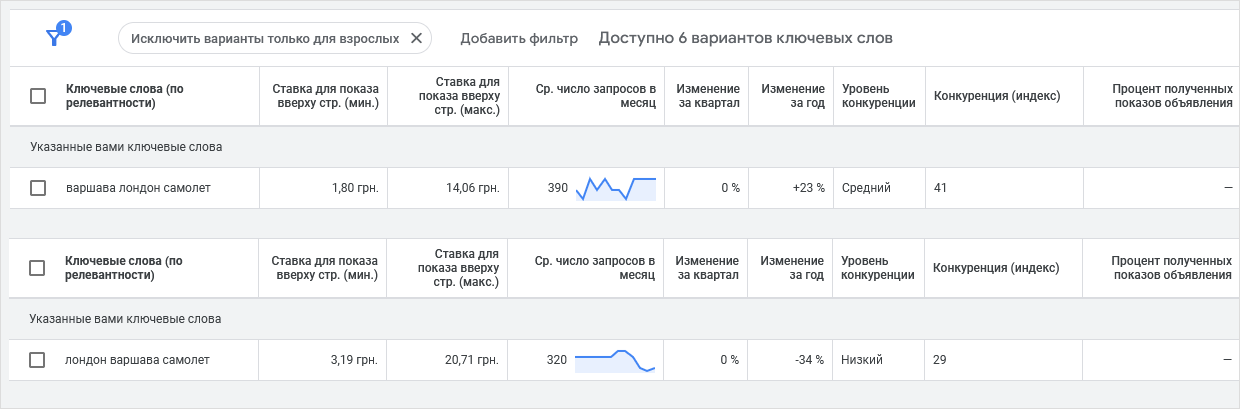

Для тематики сайтов: "туры", "авиабилеты", "перевозки", … уделяем максимальное внимание к чистке неявных дублей, не все они неявные.

Пример: "варшава лондон самолет" и "лондон варшава самолет" — это разные потребности пользователей, это разные направления переезда, разная частотность, стоимость клика и конкуренция.

Отправляем в список: "Другая причина удаления".

Пример: мы собираем все коммерческие ключи для частной кондитерской и есть запрос "торт наполеон" у него нет спецификатора определяющего намерение пользователя.

Но, в сниппетах и на страницах конкурентов будет много слов: рецепт, своими руками, как …

Установив определенный порог встречаемости стоп слов мы можем удалить нецелевые.

Отправляем в список: "Другая причина удаления".

Удаляем все запросы, у которых частотность ниже установленного порога.

◉ Для узких, дорогих, промышленных (b2b) тематик устанавливаем минимальный порог частотности = 1. Даже одна продажа в месяц дорогого продукта или услуги может несколько раз покрыть услуги по сбору и внедрению семантики на сайт.

Низкочастотные запросы расширяют общую видимость и запросный индекс сайта.

Отправляем в список: "Другая причина удаления".

Если в сем. ядре не должны быть ключи, по которым в ТОП 10 находится сразу несколько URLов одного домена. Чаще всего это брендовые запросы.

Пример: "Nescafe", "Xiaomi", ...

Отправляем в список: "Другая причина удаления".

Внимание! Есть тематики, где надо дополнительно визуально проверять списки на удаление. Пример: юридическая и медицинская тематики, где по коммерческим запросам находятся страницы с очень большими текстами и даже есть блок: "содержимое".

◉ Для коммерческого проекта оставляем запросы со смешенной и коммерческой выдачей.

Отправляем в список: "Мусор" запросы с коэффициентом коммерческости от 0 до 3.

Формула расчета параметра: Полнота = (Точная / Базовая частотность) * 100.

Запросы с коэффициентом от 0 – 3 малоэффективны.

Запросы с низкой эффективностью / полнотой, являются слишком общими или многозначными, с малой долей целевого трафика.

Отправляем в список: "Другая причина удаления".

Удаляем запросы у которых нет > 3 общих URLов в ТОП 10 с любым другим запросом из списка.

Пример: У нас после всех предыдущих этапов чистки осталось 5000 ключей по тематике "клининг помещений" и в этом списке "затаились" 2 ключа "уборка пшеницы", "уборка игра".

У этих 2 ключей правильный маркер "уборка", но не будет общих URLов с другими ключами + между ними тоже не будет связей. Это как отдельные острова возле материка.

Отправляем в список: "Мусор".

Оставшиеся ключевики мы быстро кластеризируем по Soft методу и визуально просматриваем самые большие кластера (группы).

Отправляем в список: "Мусор".

Сортируем ключи по параметрам: частотности, коммерческости, алфавиту… и ищем мусор.

Если находим, повторяем предыдущие этапы чистки, которые могут удалить недочеты.

В итоге должны остаться только наши ключевики.

Чистим те запросы, у которых сильные связи (много пересечений URLов в ТОПе) с запросами, которые мы удалили на предыдущих этапах в список "Мусор".

Пример: мы ранее удалили запрос "торт наполеон" для частной кондитерской и на данном этапе мы видим, что у этого запроса - 9 общих URLов с "торт наполеон быстро".

Значит, этот запрос с 90% долей вероятности нам тоже не подходит.

Найденные ключи также отправляем в список: "Мусор".

Лучше владельца никто не знает свой бизнес и какие запросы ему интересны!

В личном кабинете пользователя реализовано утверждение групп ключевых слов.

-

После проверки владельцем бизнеса, количество мусорных запросов в финальном списке (перед группировкой) стремится к "0"!

-

Нецелевые запросы отправляем в список: "Мусор".

9. Автоматическая кластеризация (группировка) ключевых слов по ТОПам

◉ Кластеризация по ТОПам не работает или работает очень плохо для новых, узких, низкоконкурентных тематик.

Для таких тематик, очень плохо сформирована выдача, поиск подмешивает разные типы страниц.

Распределение времени работ на 9 и 10 этапе:

- 1 этап. Основная автоматическая группировка по ТОПам (Hard, Soft, Middle) – всего лишь 5% времени.

- 2 этап. Дополнительная авто догруппировка / доразкидка по ТОПам – до 10% времени.

- 3 этап. Ручная доработка результатов автомата семантистом – до 60% времени.

- 4 этап. Ручная проверка результатов отделом качества - до 25% всего времени.

Кластеризация запросов проводиться в нашей серверной системе.

- Hard - для коммерческих проектов.

- Soft - для информационных проектов.

Для каждого кластера формируем ТОП 10 общих релевантных URLов с учетом:

- Частотности запроса.

- Позиции URLа.

- Количества запросов из кластера, по которым данный URL в ТОПе.

Для кластеризации используем различные формулы косинусного сходства (cosine similarity).

Анализируем наборы популярных слов для каждого запроса, кластера.

◉ Список популярных слов формируем из: слов запроса, сниппетов, текстов на страницах конкурентов, …

При формировании списка кластеров на объединение анализируем общие URLы ТОПе только для главной (самой частотной) фразы в кластере.

10. Ручная доработка и проверка семантического ядра

* Все работы проводим в нашей серверной системе.

* Используем различные специализированные seo инструменты и модули для ускорения ручного труда.

Поисковая выдача не идеальна. В тематиках, где вебмастера еще не создали посадочные под все интенты пользователей в один кластер могут попасть совсем разные запросы.

- Пример 1: "микрозаймы онлайн", "... без первого транша", "... круглосуточно", "... быстро".

- Пример 2: "купить свитер с оленями", "красный свитер с оленями", "синий свитер с оленями".

- Пример 3: "лего ниндзяго 11 сезон наборы", "лего ниндзяго 9 сезон наборы".

При автоматической кластеризации все попало в один кластер, и мы вручную все разносим.

В тематиках с большой конкуренцией, там, где вебмастера смотрят исключительно на выдачу, а не интенты, могут быть разные страницы, отвечающие на одну потребность пользователя.

Пример: "купить обувь куома", "купить сапоги куома", "купить валенки куома".

Все эти кластера можно объединить общую группу.

В теории это разные товары (сапоги, валенки), но по факту у этого бренда это один товар.

Все эти товары у производителя сведены на 1 общую страницу, на 1 листинг + визуально это один и тот же товар.

Для увеличения рентабельности написания статьи, допускается объединение нескольких похожих НЧ (низкочастотных) подтем в одну большую ВЧ (СЧ) тему. Перед началом объединения обязательно анализируем:

- Суммарную частотность таких кластеров.

- Создали конкуренты по подтемам отдельные страницы или нет, сколько таких статей.

◉ Удобно анализировать по наличию главного ключа в названии документов.

Пример: "как выбрать котел" + "как выбрать газовый котел" + "как выбрать электрокотел" + "как выбрать твердотопливный котел".

В товарной семантике очень часто пользователи не дописывают полностью название.

Пример запросов для одного и того же товара:

- "Aro team twinat duo" = "Aro team twinat duo 3 в 1".

- "Britax advansafix 3" = "Britax roemer advansafix iii sict".

Если разработка (формирование) семантического ядра сайта проводится только по одежде для женщин, тогда можно объединять в один кластер:

- "Купить джинсы" и "Купить джинсы для женщин".

- "Купить куртку" и "Купить куртку для женщин".

◉ В общих запросах ниже конверсия и продажи (входит спрос по мужчинам и детям) + сложнее продвинуться.

Актуально для информационных проектов. Например, в ядре есть всего 3 кластера:

- Как почистить ковер пароочистителем.

- Как почистить мягкую мебель пароочистителем.

- Как почистить подушку пароочистителем.

Связей в ТОПе нет, но кластера небольшие и их можно объединить общей проблемой: "как почистить пароочистителем".

Переносим из списка "Остались не кластеризированы" запросы в кластер с таким же интентом, но по которым еще нет связей в ТОПе.

Причина: вебмастера еще не успели найти новые запросы и добавить их на страницу (провести поисковую оптимизацию).

Мы находим такие связи по:

- Похожим наборам слов в сниппетах.

- По векторному сходству в текстах...

Типы: главная, категория (раздел, листинг, теговая страница), карточка товара, статья, отзывы, калькулятор…

11. Выгрузка и формирование всех отчетов семантического ядра

Пример:

- % Видимости релевантного URLа конкурента по определенному кластеру в поиске.

- Подбор и расчет уровня связей близких кластеров.

- Пересечение запросов ядра конкурента с нашим…

Визуально проверяем список "Мусор" и удаляем целевые маркеры.

В нем не должно быть слов, которые входят в финальный список целевых (релевантных) запросов.

Список отлично подходит для начальной настройки контекстной рекламы.

Пример: для тематики "услуги клининговой компании" в списке не должно быть слова "уборка", "клининг", "цена", "услуга", "заказать", "мойка", "чистка", "клининговая", …

Наши отчеты помогут вам эффективно провести поисковую оптимизацию страниц вашего сайта, настроить контекстную рекламу, проверить релевантность созданного контента.

Пример: "Основной отчет", "Сезонность", "Близкие кластера", "Структура", "ТОП доменов", "Самые видимые конкуренты кластера", "Тз для копирайтера", …

12. Сдача семантического ядра

Передача всех отчетов.

Zip архив доступен для скачивания в личном кабинете.

Выводы и рекомендации

| 1. | Используем чек-лист для формирования четкого плана работ по сбору семантического ядра. Вы не пропустите ни один важный этап. |

| 2. | Перед началом вы должны четко понимать, что вы должны получить в итоге, что ищем, а что удаляем. Используем анкетирование. |

| 3. | Формируем список начальных маркеров (базисов, масок) для парсинга. |

| 4. | Подбираем и детальное изучаем близких конкурентов. Главное: близких! |

| 5. | Настраиваем все инструменты. |

| 6. | Используем платные и бесплатные источники ключевых слов. |

| 7. | Собираем, парсим, собираем, парсим. |

| 8. | Чистим, внимательно чистим, фильтруем мусор. |

| 9. | Используем авто кластеризацию по ТОПам и дорабатывайте вручную. Учитываем интент запроса и специфику бизнеса. |

| 10. | Формируем удобный и визуально понятных формат отчетов. |

| 11. | Актуализация. Исследование ключевых слов должно быть непрерывным процессом. Потребности пользователей постоянно меняются. |